伝送視点での様々なテクノロジ

| application | method | distance | L2 | L1 | L0 |

|---|---|---|---|---|---|

| CPU to CPU | 400G DR4 | 500m | ethernet | 4x100G | QSFP112 |

| CPU to Memory | CXL | 10m | PCIe 5.0 | 16x32G | OSFP-XD |

| CPU to Memory | Optical I/O | 10m | 8x8x64G | CDEP | |

| GPU to GPU | UALink | 100m | 4x200G | OSFP | |

| GPU to GPU | NVLink 5.0 | 100m | 4x200G | OSFP | |

| GPU to GPU | UEC | ethernet | 4x100G | OSFP | |

| GPU to Memory | HBM3 | 20mm | 32x32x6.4G |

全体の印象

「NVL72祭り」実装の標準がNVIDIA NVL72。これに対しプラスかマイナスかで全てが語られる。

液冷のNVL72仕様のラックがあちこちの展示ブースにあり、それに対応した熱交換装置等の周辺機器をアピール。セッションでは400VDC供給、250KW/rack、1MW/rackのキーワードが多く登場し本当にそんな世界が近いうちに来るのか疑問に感じた。

食事時のテーブルでの会話では、北米でも130KW/rackの設置は簡単ではなく。NVL72がこれからのAIラックの標準構成になるとは思えないという意見もあった。

液冷

150KW/RACK

有料のコンファレンスにも関わらず七千人を超える参加者。

外部メモリーによる容量確保の必要性

CXLに代表される、外部装置の大容量メモリーをネットワーク経由で利用するシステムは遅延では不利だがその必要性を語るセッションが多くあった。一番多いシナリオは、AI LLMのモデルサイズがどんどん大きくなりAIクラスターに求められる要件が演算能力よりも保持できるメモリーのサイズが重要になると、GPUに付属するHBMのサイズには限界があるので演算能力が余ってしまう。その一方で、実際のCXLの事例はCPUからのCXLアクセスだったので疑問に感じた。

他には、SQLの大規模キャッシュへの割り当て等、GPUを用いないシステムでの優位性事例もありました。

一対一のCXLによる外部メモリーでも有用性はあるが、CXLスイッチを介したn対1のメモリープールを実現した製品があり、FC SAN的で結構すぐに利用されるのではないかと感じた。その次の同時アクセスを許すメモリーの共有に感じてはOSレベルでの対応が必要に思えるので壁は高い。

CPU/GPUによるメモリー共有も概念はわかるのだが実際のソフトウェア的な実装に課題があると思う。

META+AMD

NVIDIA対抗と思える、AMDのGPUとMETAのミドルウェアの組み合わせ。METAのソフトウェア開発力は巨大なので、既存のNVIDIA前提の様々なアプリケーション対応も可能になるかもしれない。

PCIe Gen 7.0

- Edge compute

- Near Memory Compute(NMC)

- NVIDIA MGX

モジューラーな仕様を公開。様々なベンダーが対応モジュールを製品化。AMDのEPYCマザーまである。 - UEC(Ultra Eternet)

- UALink(Ultra Access Link)

AMDが主導、NVLinkと同等。CY24末には仕様確定。

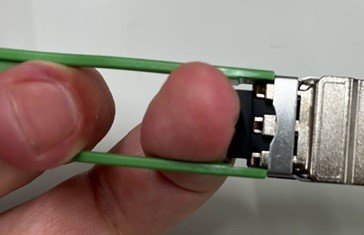

META 2x400G FR4 OSFP

16W 3km

400G NIC

- Broadcom 1400B

4x100Gと8x50G両方使える、トランシーバーソケットはQSFP112-DD。 - FBNIC(META+Marvell)

OCP Slotのみ。QSFP112

OCP ECOSYSTEM

META/AZURE/Alibaba等のハイパースケーラーが安く部品を調達する場との印象がまだまだ強いOCPだが、本来はOCPのフレームワーク下で従来のITビジネスの環境よりもディスアグリゲートされたSIが力を発揮できるマーケットを目指している。

ヨーロッパではどうなのか?

その他

- グリーンコンクリート

データーセンターを建設する際に、環境に優しい部材を使う。

OCP official youtube

https://www.youtube.com/@OpencomputeOrg/videos